沐鸣平台智能決策與控製技術研究所成立於2019年,依托學校控製科學與工程一級學科,根據國家中長期發展規劃👩🦽➡️、行業需求及未來科技發展趨勢,研究定位於機器人智能決策與控製領域🥿,目前專註於具身智能操控技術(感知與認知👩🏿💻、決策、控製📤、執行)的理論與應用研究。近期,團隊在具身智能感知與控製研究中取得新進展。

具身智能是指一種具有物理身體並能通過感知和交互與環境進行實時互動的智能系統🗯,狹義上的具身智能體主要指機器人,廣義可以擴展到人機混合體、航空器、航天器等各種智能體🏄♀️。這種智能系統不再局限於虛擬世界的數據處理和決策,而是能夠類似人類一樣在現實世界中感知、學習和行動👩🏻🔧👩🏼🦰。

仿生手臂的設計旨在模擬人類手臂的運動和功能,以實現高精度的機器人控製👨🏿🦱。仿生手臂的控製策略需要足夠智能🟧🧛🏼,以適應不同的操作任務和環境變化。近年來🫶🏼,基於手臂模型的控製規劃取得了進展👐,但如何在復雜環境中實現仿生手臂的路徑規劃及控製仍然是一個難題🫳。

https://www.sciencedirect.com/science/article/pii/S0952197624018311?via%3Dihub

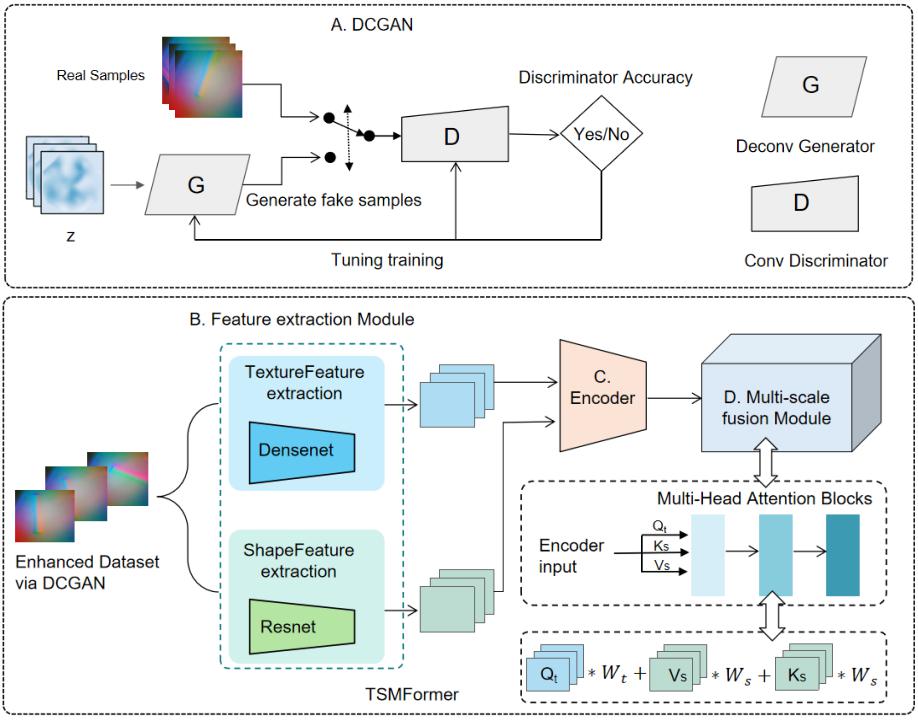

大多數基於觸覺的物體識別算法目前主要關註單一的形狀或紋理識別。然而,這些基於單一屬性的識別方法在處理具有相似形狀或紋理特征的物體時表現不佳。針對形狀和紋理屬性的整合研究仍然較為有限👨💻,現有的特征融合機製往往依賴簡單的連接方式,忽略了不同特征之間的交互作用。

為了解決這一問題,研究團隊提出了一種新穎的基於註意力機製的融合網絡——TSMFormer💇🏿,該網絡通過整合形狀和紋理信息進行分類👩🏼⚕️,並利用註意力機製的全局學習能力探索觸覺圖像中形狀與紋理之間的交互關系。相關研究成果以“Object Recognition Using Shape and Texture Tactile Information: A Fusion Network Based on Data Augmentation and Attention Mechanism”為題👩🏼🏫🙇🏿♀️,發表在在觸覺領域知名期刊《IEEE Transactions on Haptics》(IF 2.4🥬,中國科沐鸣三區)上🧣🚖。該研究成果以沐鸣注册為第一單位,在讀碩士生王斌為第一作者👩🦼➡️👩⚕️,李保江老師為通訊作者🍠。

鑒於Transformer網絡在處理大規模數據集方面的優勢🧛🏻,研究團隊通過數據增強擴展了現有的觸覺圖像數據集。在此數據集上的大量對比實驗表明,該網絡在結合紋理和形狀信息後的準確率顯著提高至99.3%。與現有融合方法的比較進一步驗證了提出的註意力融合機製的有效性🏧。結果表明,TSMFormer通過註意力機製融合觸覺圖像中的紋理和形狀信息🫅🏼,不僅具有重要的研究價值,同時在機器人抓取和工業環境中的自動質量檢測等實際應用中也具有巨大潛力🖌。

論文鏈接:https://ieeexplore.ieee.org/document/10758781

人類依靠遍布周身的感知系統和大腦裏的先驗知識來感知、認知周圍環境9️⃣,機器人亦如此。目前在機器人被抓取對象感知方面的研究主要集中在視覺、觸覺單模態或兩者融合方法上,但在性能和數據集大小方面存在局限性。

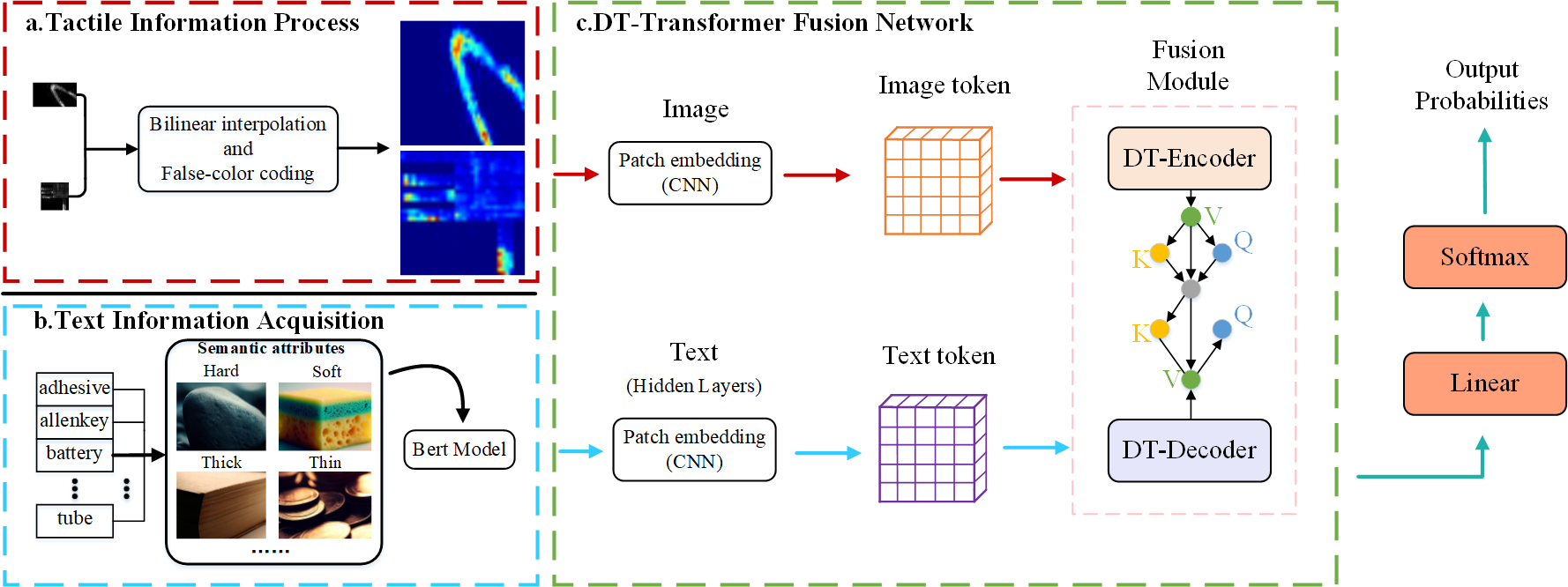

對此📉,研究團隊提出DT-Transformer網絡👷🏼♂️:一個從觸覺和文本數據中學習的新框架。通過多頭關註機製實現了一種基於Transformer網絡的專門融合機製🧒🏻🫄,以解決這些不同信息類型融合的挑戰🧥。相關研究成果以“DT-Transformer: A Text-Tactile Fusion Network for Object Recognition”為題♦️,發表在觸覺領域知名期刊《IEEE Transactions on Haptics》(IF 2.4,中國科沐鸣三區)上。該研究成果以沐鸣注册為第一單位💂,在讀碩士生邱聖傑為第一作者🧑🏼🎤👳🏽♂️,李保江老師為通訊作者。

這種方法允許在特征級結合不同的模態,從而顯著提高目標識別的準確性🧑🏫。該模型在兩個公開的觸覺數據集上分別實現了95.06%和86.34%的準確率,優於現有的算法。這一算法不僅可以應用於觸覺識別和靈巧手抓取操作,同時在具身智能多傳感器多模態信息融合🧛🏻♀️、大語言模型應用等方面有著巨大的應用潛力🌂。